Искусственный интеллект и трансформация рисков кибербезопасности

В последние годы искусственный интеллект (ИИ) стал неотъемлемой частью цифровой инфраструктуры компаний по всему миру. Особенно это касается больших языковых моделей (LLM), которые применяются для автоматизации поддержки клиентов, генерации текстов, анализа данных и даже принятия управленческих решений.

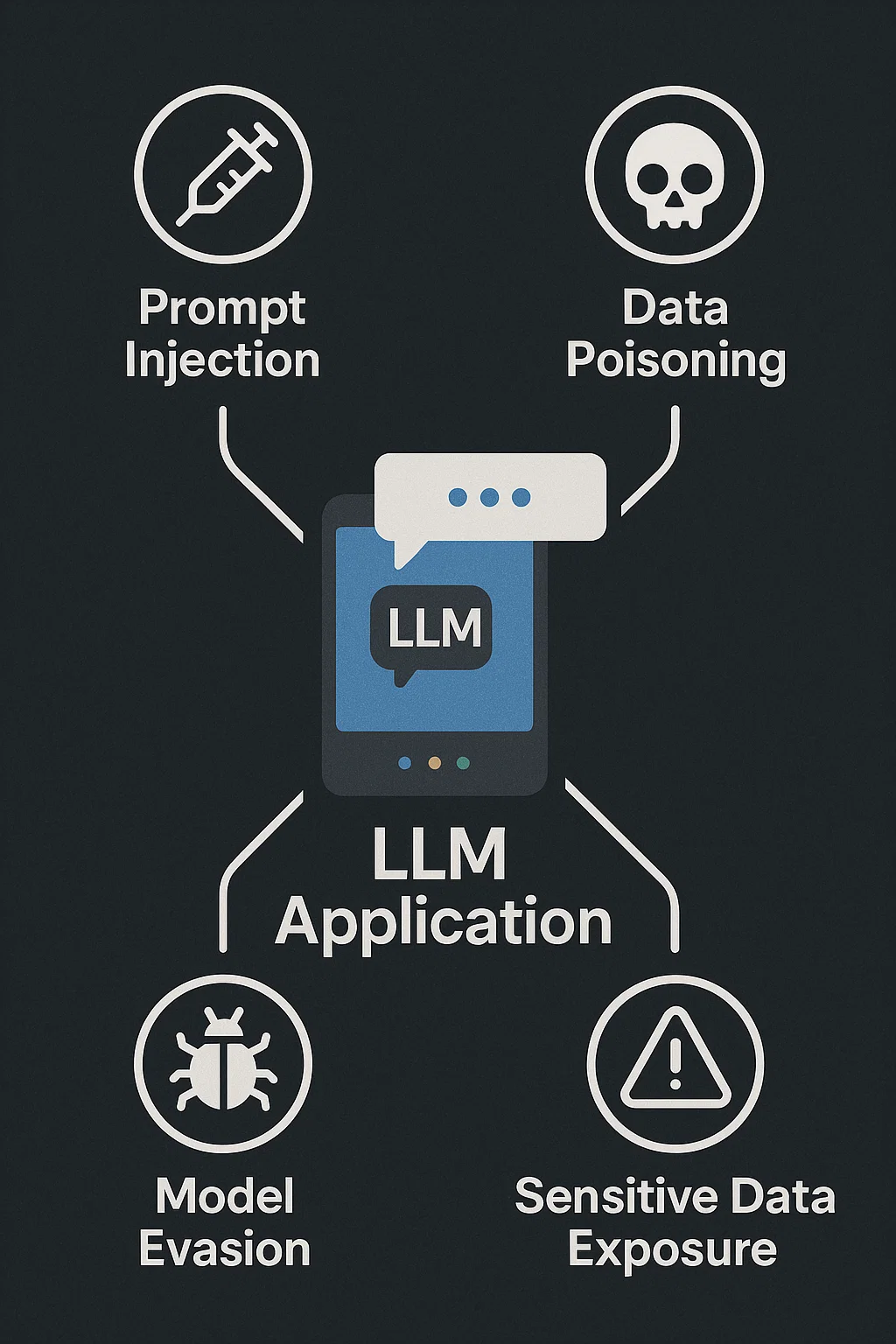

Однако масштабное внедрение LLM трансформирует ландшафт киберугроз. Если раньше атаки были направлены в основном на серверы, сети и базы данных, сегодня они всё чаще фокусируются на самой модели и её взаимодействии с пользователями. Это включает возможность манипулировать выводом модели, использовать её для распространения дезинформации или обхода корпоративной защиты.

Потенциальные угрозы от применения LLM и нейросетей

Генерация дезинформации и фейковых новостей

LLM способны создавать высококачественные тексты, которые трудно отличить от материалов, написанных человеком. Это открывает возможности для:

- Массового распространения фейковых новостей и пропаганды.

- Социальной инженерии, включая фишинг и мошеннические рассылки.

- Подделки официальных документов и публикаций.

Пример: в 2024 году эксперты обнаружили несколько случаев использования LLM для создания фейковых отчетов о финансовых результатах компаний с целью манипуляции рынком.

Алгоритмическая предвзятость и проблемы этики

LLM обучаются на больших объёмах данных, которые могут содержать культурные, социальные или гендерные предубеждения. Это приводит к рискам:

- Дискриминации в рекрутинговых системах или образовательных платформах.

- Неэтичного использования модели в медицине или финансовых сервисах.

- Генерации контента с оскорбительным или неприемлемым подтекстом.

Несанкционированное копирование и утечка ML-моделей

В 2023–2024 годах участились случаи, когда злоумышленники клонировали модели, получали доступ к обученным весам и предлагали «пиратские» версии платных сервисов. Это наносит прямой экономический ущерб и может повлиять на доверие пользователей.

Нарушение конфиденциальности и утечка персональных данных

LLM могут непреднамеренно воспроизводить информацию, на которой они обучались, включая:

- Личные данные клиентов.

- Финансовую информацию.

- Конфиденциальные корпоративные документы.

Это создаёт риски утечки данных и нарушения законов о защите персональной информации, таких как GDPR в Европе.

Читайте также: Конфиденциальность данных: простое объяснение сложной темы для новичков

Поверхность атаки и векторы рисков для LLM-приложений

Уязвимости в хранении и обработке данных

Ошибки в организации хранения данных, отсутствие шифрования и недостаточный контроль доступа увеличивают вероятность утечек или несанкционированного доступа.

Часто спрашивают: Шифрование данных на сервере: зачем нужно и как правильно настроить защиту

Манипуляции и атаки на саму модель

Adversarial-атаки позволяют изменить поведение модели или получить доступ к скрытым функциям. Примеры:

- Внедрение вредоносных паттернов в обучающие данные.

- Использование промптов, которые заставляют модель выполнять нежелательные действия.

Риски зависимостей и внешних библиотек

LLM-приложения зависят от множества внешних компонентов, включая фреймворки для машинного обучения, инструменты для API-интеграций и библиотеки для обработки данных. Уязвимость в одном компоненте может стать точкой входа для атаки на всю систему.

Угрозы в промпт-интерфейсах (prompt injection)

Злоумышленники могут вставлять специальные инструкции в промпты, заставляя модель раскрывать данные или обходить ограничения. Пример: пользователь формирует запрос, который заставляет LLM раскрыть внутренние конфигурации API.

Уязвимости в RAG-компонентах и базе знаний

Интеграция Retrieval-Augmented Generation (RAG) расширяет возможности LLM, но и увеличивает поверхность атаки:

- Подмена источников информации.

- Внедрение недостоверных данных в базу знаний.

- Обход ограничений модели через внешние документы.

Опасности при работе LLM-агентов

Автономные LLM-агенты могут взаимодействовать с другими сервисами без постоянного контроля, что создаёт угрозы:

- Неожиданное выполнение команд.

- Доступ к API и внешним сервисам без ограничений.

- Распространение вредоносных запросов в корпоративной сети.

Проблемы безопасности API-интеграций

Ошибки в конфигурации API, недостаточная аутентификация или слабые токены создают риски для:

- Утечки корпоративных данных.

- Доступа к LLM для злоумышленников.

- Массовых атак на клиентов сервиса.

Угрозы цепочки поставок (Supply Chain Attacks)

Интеграция сторонних моделей, библиотек и инструментов ML может стать точкой входа для атак. Пример: заражённые пакеты PyPI или NPM, используемые для обучения или генерации данных, могут внедрять вредоносный код.

Риски для конечных пользователей, разработчиков и администраторов

- Фишинг и социальная инженерия через LLM.

- Ошибочные действия администраторов под влиянием недостоверного вывода моделей.

- Повышенные требования к квалификации разработчиков для безопасного внедрения и поддержки.

Роль государства и международных организаций в регулировании ИИ

Регулирование ИИ становится глобальной темой:

- ЕС: AI Act требует прозрачности, аудитов и ограничений для высокорисковых приложений.

- США: NIST разрабатывает стандарты оценки рисков и безопасности ИИ.

- Международные инициативы: ООН и ISO разрабатывают принципы безопасного и этичного использования LLM.

Эти меры направлены на защиту пользователей, минимизацию рисков утечек данных и предотвращение распространения вредоносного контента.

Практические рекомендации бизнесу по безопасному внедрению LLM

- Проводить регулярные аудиты безопасности и тестирование на проникновение.

- Минимизировать хранение персональных данных и использовать шифрование.

- Защищать промпт-интерфейсы от injection-атак.

- Контролировать интеграции с внешними библиотеками и API.

- Настраивать мониторинг активности LLM-агентов и RAG-систем.

- Разрабатывать корпоративные политики и обучать сотрудников кибербезопасности.

Итоговые выводы

LLM открывают новые возможности для бизнеса, науки и государственного сектора. Вместе с тем, они создают уникальные угрозы: от генерации дезинформации до утечек данных и атак на модели. Без комплексного подхода к безопасности и соблюдения международных стандартов использование LLM может стать риском для компаний и конечных пользователей. Инвестирование в киберзащиту, этику и аудит моделей сегодня становится стратегическим преимуществом завтра.