Основы балансировки нагрузки

Проблемы высокой нагрузки и как с ними справляется балансировка

С ростом количества пользователей на веб-ресурсе резко возрастает нагрузка на вычислительные ресурсы. Один сервер может не справляться с обработкой всех обращений, что приводит к задержкам, отказам в обслуживании и падению производительности. Здесь на помощь приходит распределение трафика, позволяющее направлять клиентские обращения на несколько узлов, оптимизируя производительность и минимизируя простои.

Балансировка позволяет обеспечить равномерное распределение вычислительной нагрузки между разными инстансами. Это помогает избежать перегрузки одного сервера и поддерживать стабильную работу веб-приложения даже при пиковых всплесках трафика.

Разница между VPS и VDS в контексте распределения трафика

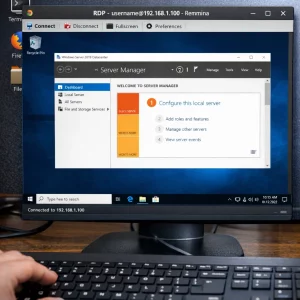

При выборе инфраструктуры важно понимать различие между VPS и VDS. По сути, оба термина обозначают виртуальные выделенные среды, но иногда различия кроются в уровне виртуализации. VPS часто использует контейнерную изоляцию, в то время как VDS базируется на аппаратной эмуляции, что дает большую гибкость в настройке.

Для целей балансировки нагрузки и масштабируемости, VDS может предоставить более стабильную производительность при высоком числе параллельных соединений. Это особенно актуально, если вы планируете использовать Nginx в качестве распределяющего трафик узла.

Читайте также: Виртуальный хостинг против выделенного: какой вариант станет лучшим решением?

Обзор современных решений для балансировки сетевых запросов

Помимо Nginx, популярными решениями являются HAProxy, Traefik, Envoy и AWS Elastic Load Balancer.

Однако Nginx отличается простотой, легкостью конфигурации и высокой производительностью, что делает его идеальным выбором для большинства задач по распределению входящих обращений.

Использование Nginx как балансировщика

Как установить и подготовить Nginx на сервере Ubuntu

Для начала потребуется установка самого веб-сервера Nginx. Введите следующие команды на вашей Ubuntu-машине:

sudo apt update sudo apt install nginx

После установки проверьте статус сервиса:

sudo systemctl status nginx

Если сервис работает корректно, можно переходить к его конфигурации как балансировщика.

Настройка конфигурации Nginx для балансировки

Откройте конфигурационный файл, например:

sudo nano /etc/nginx/conf.d/load_balancer.conf

Пример базовой конфигурации для равномерного распределения обращений между двумя узлами:

upstream backend {

server backend1.example.com;

server backend2.example.com;

}

server {

listen 80;

location / {

proxy_pass <http://backend>;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

}

}

Эта схема позволяет перенаправлять пользовательские обращения на свободные сервера, обеспечивая отказоустойчивость и гибкость.

Алгоритмы распределения трафика

Последовательное распределение (Round Robin)

Самый простой алгоритм — последовательное перенаправление клиентских обращений по кругу. Каждый новый запрос направляется на следующий сервер в списке, что обеспечивает равномерную нагрузку.

Преимущества:

- Простота реализации

- Не требует дополнительного учета состояния

Недостатки:

- Не учитывает текущую загруженность серверов

Балансировка по наименьшему количеству подключений

Алгоритм выбирает сервер, имеющий минимальное количество активных соединений. Это особенно эффективно при обслуживании соединений с длительным временем отклика.

Пример настройки:

upstream backend {

least_conn;

server backend1.example.com;

server backend2.example.com;

}

Привязка по IP-адресу клиента (IP Hash)

Используется для привязки клиента к одному и тому же серверу на основе его IP-адреса. Это необходимо для приложений, где важна сессия пользователя.

upstream backend { ip_hash; server backend1.example.com; server backend2.example.com; }

Настройка обработки ошибок и отказоустойчивости

Можно настроить резервные узлы и обработку отказов:

upstream backend {

server backend1.example.com;

server backend2.example.com backup;

}

Кроме того, параметры вроде max_fails и fail_timeout позволяют точно контролировать логику восстановления:

server backend1.example.com max_fails=3 fail_timeout=30s

Сравнение алгоритмов: таблица характеристик и сценарии использования

| Алгоритм | Особенности | Подходит для |

| Round Robin | Прост, равномерное распределение | Статичные сайты, простые API |

| По наименьшему количеству подключений | Учет текущей загрузки | Чат-сервисы, стриминг |

| IP Hash | Стабильное соединение клиента | Интернет-магазины, CRM-системы |

Это интересно: Nginx и Node.js: В чем ключевые отличия и что выбрать?

Подведение итогов

Балансировка сетевой активности — это неотъемлемая часть современной инфраструктуры, особенно при использовании виртуальных сред. Nginx зарекомендовал себя как легковесный, но мощный инструмент для маршрутизации обращений, повышая отказоустойчивость и скорость отклика сервисов.

Выбирая между VPS и VDS, важно учитывать особенности работы вашего приложения и предполагаемый объем трафика. С помощью грамотно настроенного алгоритма маршрутизации можно достичь высокой производительности без существенных затрат.

Понимание различий между алгоритмами распределения и правильная настройка соединений позволяет создать гибкую, масштабируемую архитектуру, устойчивую к пиковым нагрузкам. И всё это — при помощи компактного и мощного инструмента под названием Nginx.